発展的なクラスタリングの話題

多変量解析や機械学習の一手法として、与えられたデータから特徴を取り出して類似のデータたちをまとめるクラスタリングがあります。クラスタリングの入門的な解説でよく扱われる手法として、データが量的変数であるような場合のk-means法・Ward法があります。

本講座ではそこから一歩先に進んで、より発展的なクラスタリングの話題について触れていきます

※アーカイブ講座の動画販売についてお申し込み受付中です。

統計・機械学習講座

スポット講座

Aアドバンス

アーカイブ講座(録画販売中)

多変量解析や機械学習の一手法として、与えられたデータから特徴を取り出して類似のデータたちをまとめるクラスタリングがあります。クラスタリングの入門的な解説でよく扱われる手法として、データが量的変数であるような場合のk-means法・Ward法があります。

本講座ではそこから一歩先に進んで、より発展的なクラスタリングの話題について触れていきます

※アーカイブ講座の動画販売についてお申し込み受付中です。

多変量解析や機械学習の一手法として、与えられたデータから特徴を取り出して類似のデータたちをまとめるクラスタリングがあります。クラスタリングの入門的な解説でよく扱われる手法として、データが量的変数であるような場合のk-means法・Ward法があります。本講座ではそこから一歩先に進んで、より発展的なクラスタリングの話題について触れていきます。今回は、

を紹介します。各手法を説明するにあたっては、Python言語によるコーディング例を与え、またアルゴリズムのアイディアを数学の言葉を使いながら説明することで、ある程度のイメージを掴んでもらうことを目標にします。

すうがくぶんかのオリジナルテキスト

デジタルデータ(jupyter)をメール添付にてお送りいたします

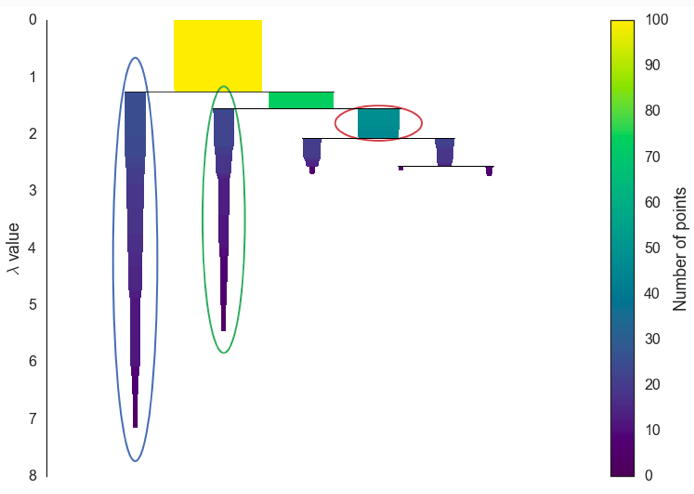

k-means法やWard法は、データが量的変数だけから出来ていることを想定しています。一方、カテゴリ変数が入った時には、データ点の間の距離の測り方をよく考えないと不自然に見えるという問題点があります。そこで、Gower距離と言うカテゴリ変数を含むデータにおけるデータ点の間の距離を紹介し、これを用いたクラスタリング(例えばk-prototype, Gower距離を用いた階層クラスタリング)を説明します。

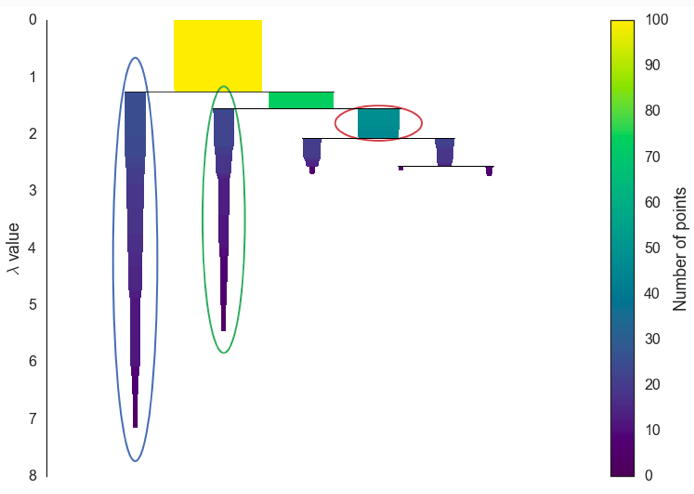

クラスターを作るアイディアの一つに、散布図上のデータ点の密集しているところを一つのクラスターにまとめるというものが考えられます。これは密度準拠型クラスタリングと呼ばれているものです。この手法はk-means法やWard法とは異なったアイディアに基づいているため、k-means法やWard法ではうまくクラスタリングが出来なくても、密度準拠型クラスタリングならうまくクラスタリングできるという場合があります。今回は、密度準拠型クラスタリングの例としてDBSCANとHDBSCANを学んでいきます。

| 講座名 | クラスタリングの発展的な話題:機械学習の数理シリーズ |

|---|---|

| 担当講師 | |

| 開講スケジュール |

計2回の集中講義になります。 |

| 受講方法 |

Zoomによるオンライン講座 |

| 教科書 | すうがくぶんかのオリジナルテキスト |

| 受講料 | 全2回 税込34,500円 |

| お支払い方法 |

クレジットカード支払いは本ページ下部「受講料のお支払いについて」よりお願いいたします。 |

| 準備物 | ・筆記用具 |

下記のボタンを押すと該当する集団講座のチケットをご購入いただけます。

※ボタンを押すと、stripeの決済ページへ遷移します。

| 全2回 |

|---|

2020年前期分よりオンライン授業を録画し、授業の録画販売(アーカイブ販売)を行っております。

アーカイブ講座の動画購入をご検討いただく場合は、下記についてご確認をお願いいたします。

本講座は開講中の講座はございません。

アーカイブ講座(録画購入)にてご受講いただけます。

アーカイブ講座(録画購入)のお申し込みはこちら

| 講座名 | 動画内容 | 講師名 | 受講料 |

|---|---|---|---|

| クラスタリングの発展的な話題:機械学習の数理シリーズ 2020年後期 |

全2回 | 内場 崇之 | 34,500円 |

年度別 講座情報

| 年度 | 講座情報 |

|---|---|

| ー | 本講座は2020年後期のみの開講です。 |

講座のお申し込み・ご相談は

気軽にお問い合わせください。