基礎から学べる機械学習の理論とPythonによる実践

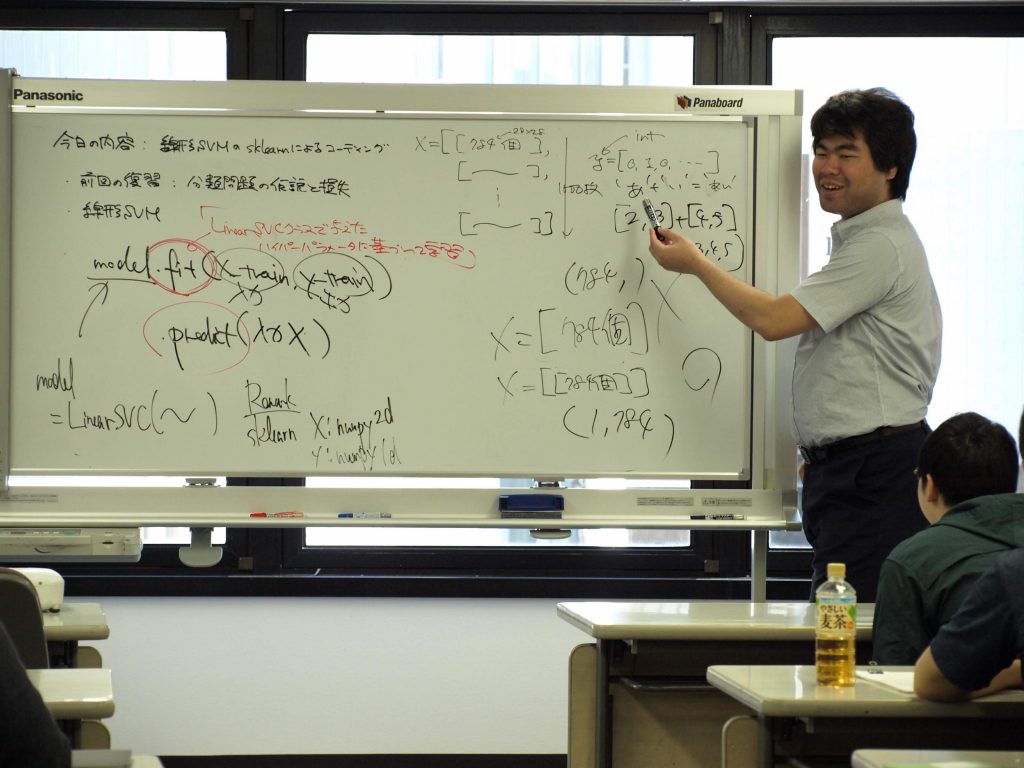

本講座では、機械学習の理論を数学や統計学による解釈をしっかり踏まえながら講義します。また、理論のみではなく、Pythonの機械学習パッケージを用いて実装と一緒に学んでいきます。

※アーカイブ講座の動画販売についてお申し込み受付中です。

統計・機械学習講座

通常講座

Sスタンダード

アーカイブ講座(録画販売中)

本講座では、機械学習の理論を数学や統計学による解釈をしっかり踏まえながら講義します。また、理論のみではなく、Pythonの機械学習パッケージを用いて実装と一緒に学んでいきます。

※アーカイブ講座の動画販売についてお申し込み受付中です。

機械学習が活用されたサービスは需要予測やコンピュータビジョン、レコメンドシステムなど着実に社会に浸透しつつあります。私たちは機械学習を理解することで、これまでは困難とされるようなビジネス課題にも、クリエイティブに挑戦できる可能性があります。

この講座は、機械学習に興味があって自分でエンジニアリングしてみたい、または機械学習を実際にエンジニアリングしているが数学や統計学による理解には自信がないという方を対象にしています。より具体的には、

1. 機械学習の各手法の理解

2. 前処理や特徴量抽出、モデル評価の理解

を数学や統計学による解釈をしっかり踏まえながらサポートし、初歩的な機械学習エンジニアリングが適切に出来るようになることを目指します。

すうがくぶんかのオリジナルテキスト

デジタルデータ(PDF)をメール添付にてお送りいたします

・機械学習を数学的な表現を通して理解できるようになること

・機械学習の各手法を実践的な課題に対して適切に応用できるようになること

・高校数学IA, IIB (大人のための高校数学IIB)

・Pythonに関する初歩的な知識(基礎から学ぶPython講座)

– 機械学習が活躍している場面

– 機械学習のフレームワーク

– 基本操作

– パッケージ

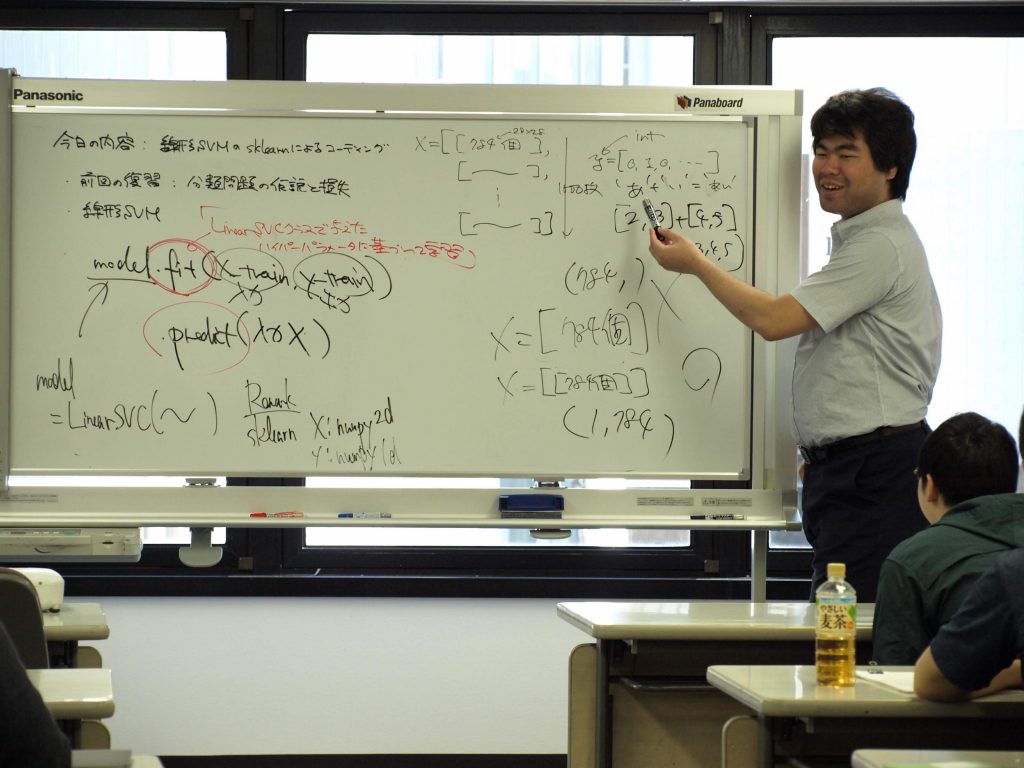

– 線形回帰モデル

– 決定係数

– 線形回帰を用いた予測の具体例

– ロジスティック回帰モデル

– ロジスティック回帰モデルを用いた手書き文字画像の分類

– クラスタリングとは

– k-means法

– k-means法のsklearnによる実装

– k-means法の性質

– 行列

– 演算

– 次元削減とは

– 主成分分析の仕組み

– sklearnによる実装

– 標準化得点とマハラノビス距離

– マハラノビス距離学習

– 決定木回帰の学習

– 決定木回帰の性質

– 多次元の入力に対する決定木回帰と分割領域

– 変数重要度

– ランダムフォレスト回帰の性質

– ランダムフォレスト回帰による変数重要度

– 線形サポートベクトルマシン

– カーネルサポートベクトルマシン

– 階層クラスタリング

– 階層クラスタリングの仕組み

– scipyによる実装

– 凝集型階層クラスタリングに求められる解釈可能性

– クラスタリングタスクの洗い出し

– 内的妥当性尺度

– モデル評価

– モデル選択

– 数理最適化とは

– UMAPの実装

– 多次元尺度構成法との比較

– crowding problem

– 次元の呪い

– LIME

– SHAP

– IsorationForest

– IsorationForestの実行

– タスクの説明

– 訓練データの読み込み

– ベースになる機械学習モデルの学習

– 物体検出器の実装

– 物体検出のデモ

| 講座名 | Pythonで学ぶ機械学習 |

|---|---|

| 担当講師 | |

| 開講スケジュール |

土曜クラス : 10:00-12:00

2023年10月14日~2024年3月23日

*2023年10月14日開講に変更となりました

12月30日土曜日は休講です。 ※詳細はこちらのカレンダーをご確認ください。 |

| 受講方法 |

Zoomによるオンライン講座 授業は録画されます。録画(アーカイブ動画)は授業終了から5年間オンラインにて繰り返しご視聴いただけます。(ダウンロード不可) 詳細はこちらのページをご確認ください。 |

| 教科書 | すうがくぶんかのオリジナルテキスト |

| 受講料 | 税込24,500円/期(税込122,500円/5期一括) ※お支払い期日の詳細はこちらのカレンダーをご確認ください。 |

| お支払い方法 |

クレジットカード支払いは本ページ下部「受講料のお支払いについて」よりお願いいたします。 |

| 準備物 | ・筆記用具 |

| その他 | 初回講義での体験受講が可能です。 |

下記のボタンを押すと該当する集団講座のチケットをご購入いただけます。

※ボタンを押すと、stripeの決済ページへ遷移します。

| 1期分 | 2期分 | 5期一括 |

|---|---|---|

2020年前期分よりオンライン授業を録画し、授業の録画販売(アーカイブ販売)を行っております。

アーカイブ講座の動画購入をご検討いただく場合は、下記についてご確認をお願いいたします。

本講座は開講中の講座はございません。

アーカイブ講座(録画購入)にてご受講いただけます。

アーカイブ講座(録画購入)のお申し込みはこちらから

| 講座名 | 動画内容 | 講師名 | 受講料 |

|---|---|---|---|

| Pythonで学ぶ機械学習 2023年後期 |

全20回 (各120分) |

中村 伸一郎 | 24,500円/期(122,500円 /5期一括) |

| Pythonで学ぶ機械学習 2022年前期 |

全19回 (各120分) |

伊集院 拓真 | 24,500円/期(122,500円 /5期一括) |

| Pythonで学ぶ機械学習 2021年後期 |

全19回 (各120分) |

伊集院 拓真 | 24,500円/期(122,500円 /5期一括) |

| Pythonで学ぶ機械学習 2021年前期 |

全19回 (各120分) |

佐藤 秋彦 | 24,500円/期(122,500円 /5期一括) |

| Pythonで学ぶ機械学習 2020年前期 |

全19回 (各120分) |

佐藤 秋彦 | 24,500円/期(122,500円 /5期一括) |

年度別 講座情報

| 年度 | 講座情報 |

|---|---|

| 全年度共通 | 本講座はカリキュラム等について全年度共通です。 |

講座のお申し込み・ご相談は

気軽にお問い合わせください。