Transformerの仕組みとコーディング例を解説

多岐にわたる応用が拡がるTransformerを、テキスト・画像分類にスポットを当てて解説します。

コーディング実例を交え、BERTやAttention Mapを利用した応用例も紹介。

Transformerの仕組みとその応用について学んでいきましょう。

※2023年12月のご受講についてお申し込み受付中です。アーカイブ視聴による参加も可能です。

統計・機械学習講座

スポット講座

Sスタンダード

アーカイブ講座(録画販売中)

多岐にわたる応用が拡がるTransformerを、テキスト・画像分類にスポットを当てて解説します。

コーディング実例を交え、BERTやAttention Mapを利用した応用例も紹介。

Transformerの仕組みとその応用について学んでいきましょう。

※2023年12月のご受講についてお申し込み受付中です。アーカイブ視聴による参加も可能です。

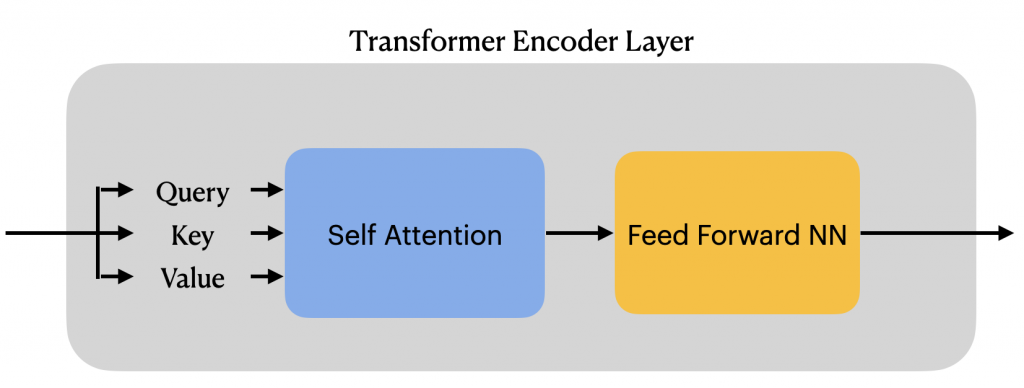

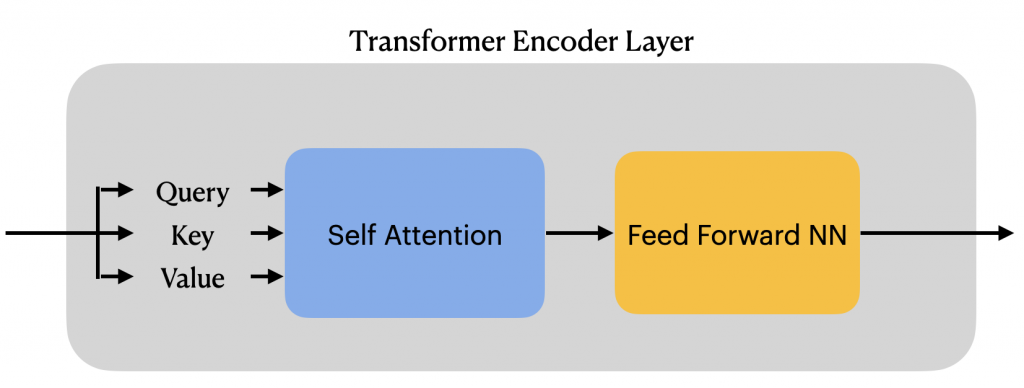

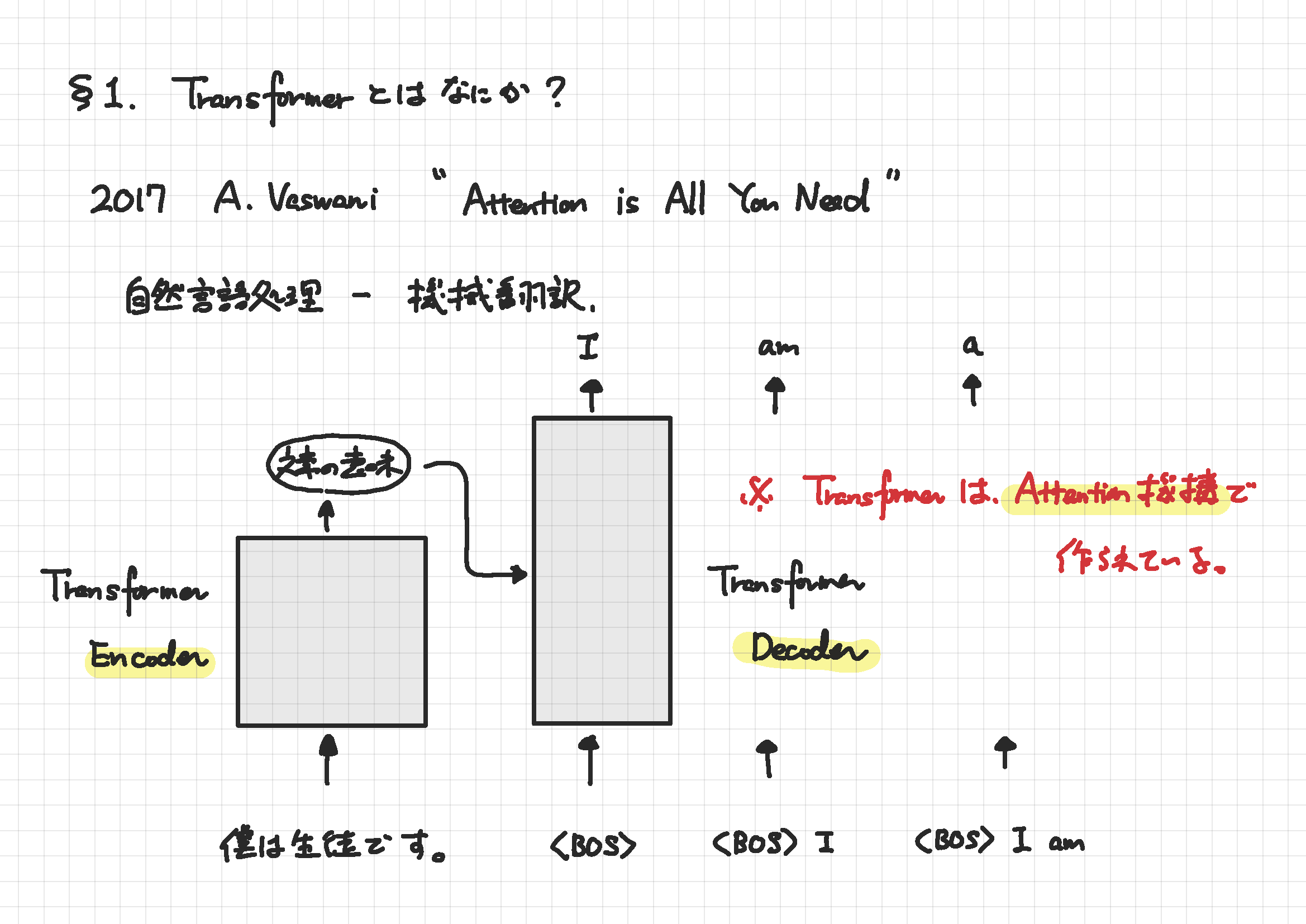

“Attention Is All You Need”

これは、2017年に発表されたある論文のタイトルです。この論文で提案されたモデルは、DeepLやGoogle翻訳に代表される機械翻訳の最高精度を叩き出し、この5年間のうちに自然言語処理に収まらず、時系列予測、画像認識にまで制空権を拡大してきました。その名前こそ、Transformerです。

Transformerは、需要予測、テキスト分類、機械翻訳、文章生成、画像分類、物体検出などあらゆる機械学習課題に浸透しつつあります。そこで、この講座ではTransformerを知りたい、使ってみたいという方を対象に

・テキスト分類・画像分類

に絞って、Transformerの仕組みとコーディング例を解説します。

また、事前学習モデルであるBERTの応用や、Attention Mapを用いたTransformerの予測根拠の可視化についても触れます。

すうがくぶんかのオリジナルテキスト

デジタルデータ(jupyter)をメール添付にてお送りいたします

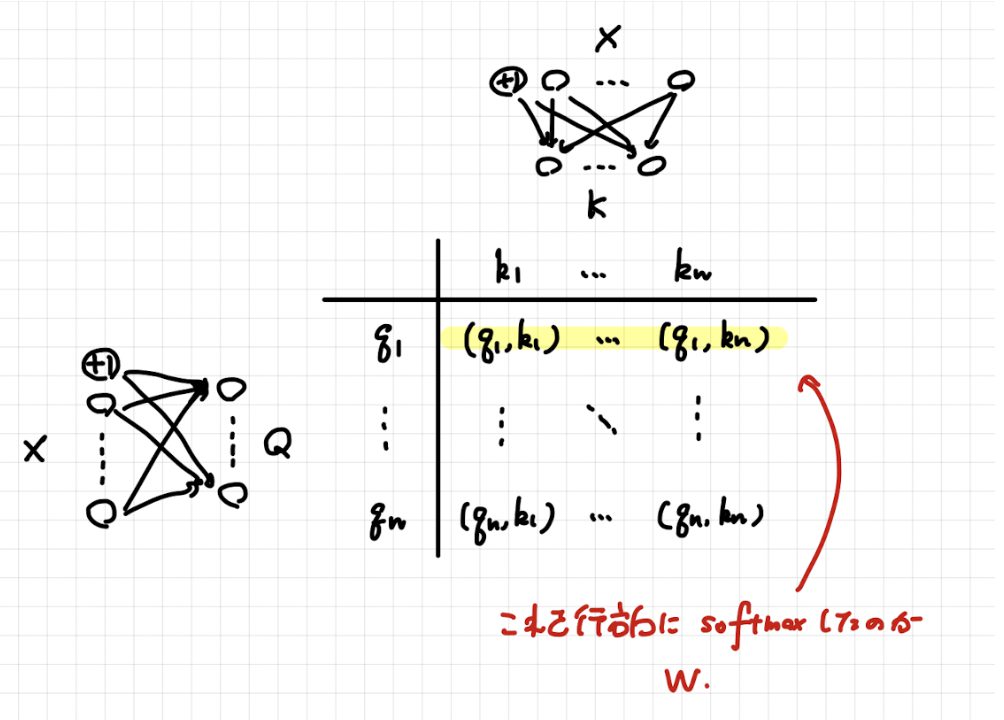

前半はニュースに対してそのカテゴリを分類するような「テキスト分類」という課題を例に、Transformerの仕組みを解説し、PyTorchによるコーディング例を紹介します。また、同様の例を用いてBERTとよばれるモデルの紹介やデモを行います。最後に、Attention Mapの可視化によってどの単語に注目して分類結果が決まったのかを推察できる話についてもデモを行います。

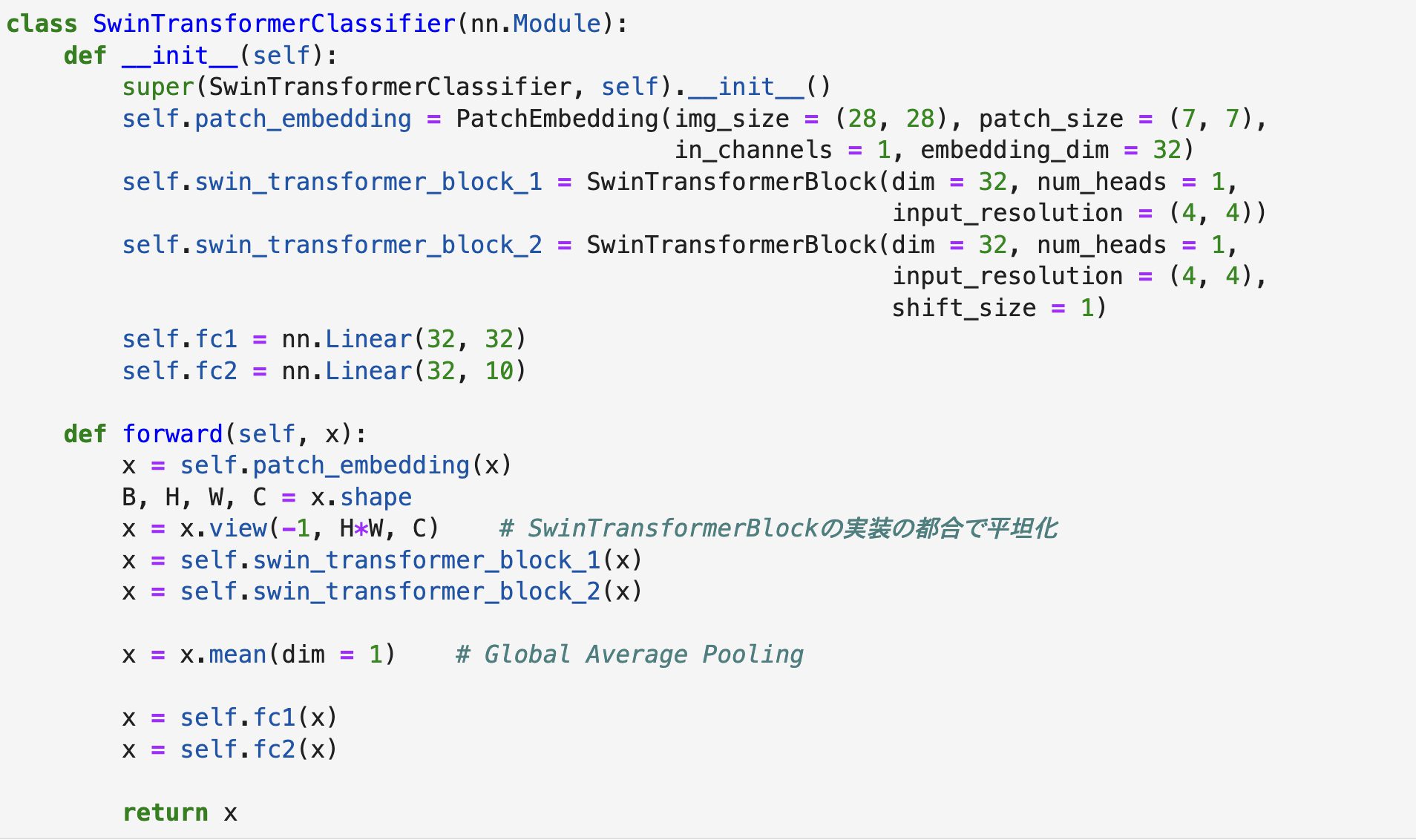

後半は、手書き文字画像に対して書かれている文字ラベルを分類するような「画像分類」という課題を例に、画像データへTransformerを用いてアプローチする方法を2種類紹介します。一つは旧来から使われているVision Transformer (ViT)、もう一つは最近話題のSwin Transformerです。ViTからSwin Transformerにかけて、画像データ特有の性質をTransformerにどう取り込んだのかを解説します。

| 講座名 | Transformerとその周辺:機械学習の数理シリーズ |

|---|---|

| 担当講師 | |

| 開講スケジュール |

全2回 |

| 受講方法 |

Zoomによるオンライン講座 |

| 教科書 | すうがくぶんかのオリジナルテキスト |

| 受講料 | 全2回 税込34,500円 |

| お支払い方法 |

クレジットカード支払いは本ページ下部「受講料のお支払いについて」よりお願いいたします。 |

| 準備物 | ・PyTorchをインストールしたPython言語環境があるPC |

下記のボタンを押すと該当する集団講座のチケットをご購入いただけます。

※ボタンを押すと、stripeの決済ページへ遷移します。

| 全2回 | 1回 |

|---|---|

2020年前期分よりオンライン授業を録画し、授業の録画販売(アーカイブ販売)を行っております。

アーカイブ講座の動画購入をご検討いただく場合は、下記についてご確認をお願いいたします。

本講座は開講中の講座はございません。

アーカイブ講座(録画購入)にてご受講いただけます。

アーカイブ講座(録画購入)のお申し込みはこちら

| 講座名 | 動画内容 | 講師名 | 受講料 |

|---|---|---|---|

| Transformerとその周辺:機械学習の数理シリーズ 2022年後期 |

全2回 | 内場 崇之 | 34,500円 |

| Transformerとその周辺:機械学習の数理シリーズ 2023年後期 |

全2回 | 竹川 洋都 | 34,500円 |

年度別 講座情報

| 年度 | 講座情報 |

|---|---|

| 全年度共通 | カリキュラムに大幅な違いはございません。 |

講座のお申し込み・ご相談は

気軽にお問い合わせください。