ブースティング系の手法の数理について解説

この講義では現在機械学習の手法として隆盛を極めている、ブースティング系の手法の数理について解説します。

ブースティングの基本的なアイデアを説明し、変数重要度の計算、XGBoost, LightGBMの説明までを行います。

※アーカイブ講座の動画販売についてお申し込み受付中です。

統計・機械学習講座

スポット講座

Aアドバンス

アーカイブ講座(録画販売中)

この講義では現在機械学習の手法として隆盛を極めている、ブースティング系の手法の数理について解説します。

ブースティングの基本的なアイデアを説明し、変数重要度の計算、XGBoost, LightGBMの説明までを行います。

※アーカイブ講座の動画販売についてお申し込み受付中です。

この講座は機械学習の数理シリーズです。

ブースティングはKarns-Valiant問題(1988, 1989)に、Shapire(1990)が肯定的な結果を出したことに端を発します。大雑把に説明すると「あまり精度の良くない予測器から高い精度の予測器を作る」手法の例としてブースティングは提案されました。

Shapire(1990)の結果を受けて、実用的なブースティング手法の研究が進んできました。代表例として

などが提案され、いずれも機械学習の代表的な手法として定着しています。

すうがくぶんかのオリジナルテキスト

デジタルデータ(jupyter)をメール添付にてお送りいたします

この講座では、

の3つに注目して解説します。

一般的なブースティング手法に見られる学習アルゴリズムの共通点を事前に説明します。そして、アルゴリズムの実例としてAdaBoostアルゴリズムを紹介し、簡単なデータセットを用いたAdaBoostのデモンストレーションを行います。また、AdaBoostの統計モデルとしての解釈を与え、AdaBoostへの理解を深めます。

Friedmanが提案したGradient Boostingの学習アルゴリズムについて勾配降下法を参考にしながら説明し、簡単なデータセットを用いたGradient Boostingのデモンストレーションを行います。また、アルゴリズムの収束性・早期終了(early stopping)・変数重要度の計算方法について紹介します。

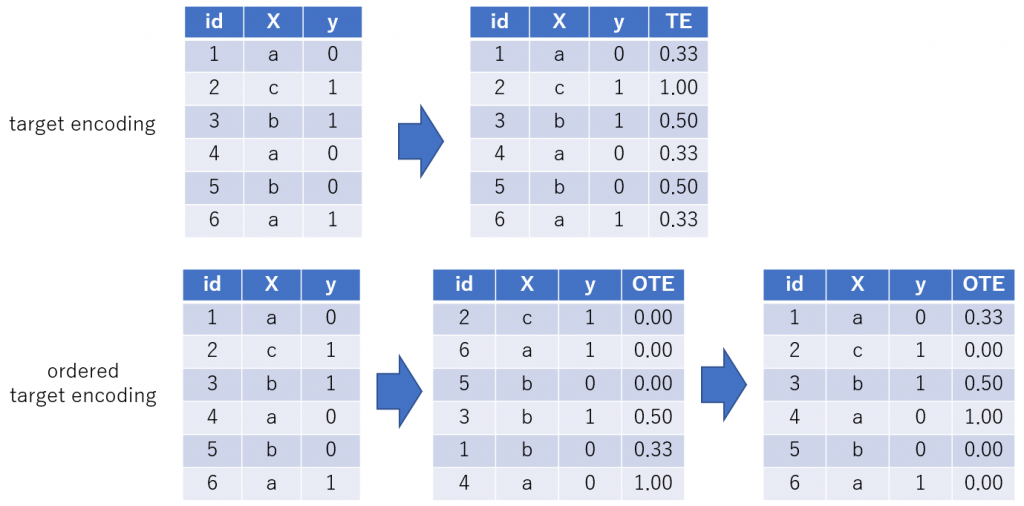

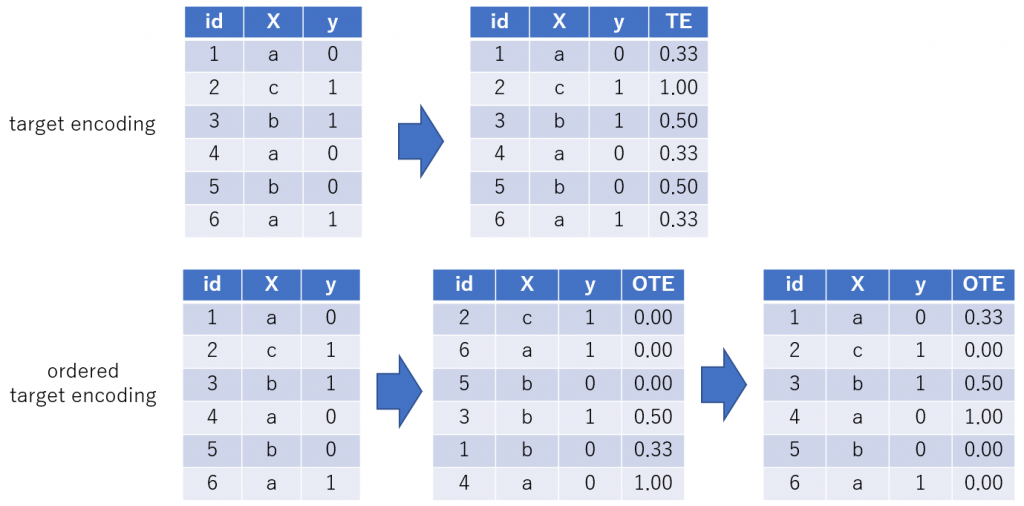

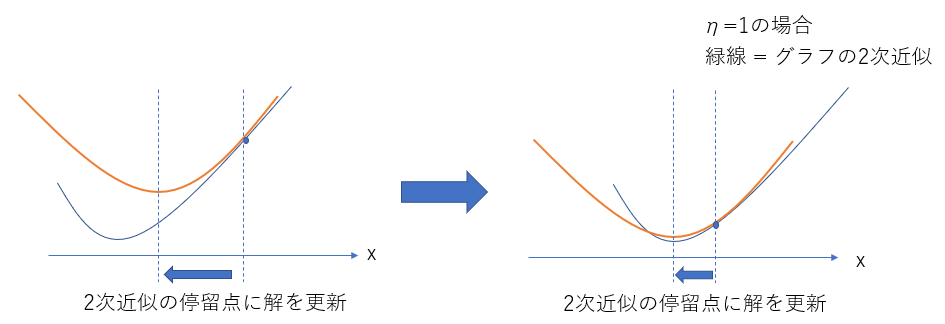

Chen-Guestrinが提案したXGBoostの学習アルゴリズムについてNewton法を参考にしながら説明し、簡単なデータセットを用いたXGBoostのデモンストレーションを行います。また、XGBoostに改良を加えたLightGBMを紹介し、LightGBMにおける変数重要度の計算方法・カテゴリ変数のエンコーディング (adaptive encoding)・欠測の扱いについて紹介します。

| 講座名 | ブースティング入門:機械学習の数理シリーズ |

|---|---|

| 担当講師 | |

| 開講スケジュール |

計2回の集中講義になります。 |

| 受講方法 |

Zoomによるオンライン講座 |

| 教科書 | すうがくぶんかのオリジナルテキスト |

| 受講料 | 全2回 税込34,500円 |

| お支払い方法 |

クレジットカード支払いは本ページ下部「受講料のお支払いについて」よりお願いいたします。 |

| 準備物 | ・筆記用具 |

下記のボタンを押すと該当する集団講座のチケットをご購入いただけます。

※ボタンを押すと、stripeの決済ページへ遷移します。

| 全2回 |

|---|

2020年前期分よりオンライン授業を録画し、授業の録画販売(アーカイブ販売)を行っております。

アーカイブ講座の動画購入をご検討いただく場合は、下記についてご確認をお願いいたします。

本講座は開講中の講座はございません。

アーカイブ講座(録画購入)にてご受講いただけます。

アーカイブ講座(録画購入)のお申し込みはこちら

| 講座名 | 動画内容 | 講師名 | 受講料 |

|---|---|---|---|

| ブースティング入門:機械学習の数理シリーズ 2020年前期 |

全2回 | 内場 崇之 | 34,500円 |

年度別 講座情報

| 年度 | 講座情報 |

|---|---|

| ー | 本講座は2020年前期のみの開講です。 |

講座のお申し込み・ご相談は

気軽にお問い合わせください。